Модели больших языков (LLM): полное руководство в 2023 г.

Все, что вам нужно знать о LLM

Таблица указателей

Скачать электронную книгу

Введение

Вы когда-нибудь чесали затылок, поражаясь тому, как Google или Alexa, казалось, вас «достали»? Или вы обнаружили, что читаете сгенерированное компьютером эссе, которое звучит жутко по-человечески? Ты не один. Пришло время приподнять завесу и раскрыть секрет: модели больших языков, или LLM.

Что это, спросите вы? Думайте о LLM как о скрытых волшебниках. Они поддерживают наши цифровые чаты, понимают наши запутанные фразы и даже пишут так же, как мы. Они меняют нашу жизнь, превращая научную фантастику в реальность.

Это руководство посвящено всем вопросам, связанным с LLM. Мы исследуем, что они могут делать, чего они не могут и где они используются. Мы рассмотрим, как они влияют на всех нас простым и понятным языком.

Итак, давайте начнем наше увлекательное путешествие в LLM.

Для кого предназначено это руководство?

Это обширное руководство предназначено для:

- Все вы, предприниматели и индивидуальные предприниматели, которые регулярно обрабатывают огромные объемы данных.

- Искусственный интеллект и машинное обучение или профессионалы, начинающие знакомство с методами оптимизации процессов

- Руководители проектов, которые намерены ускорить вывод на рынок своих модулей ИИ или продуктов на основе ИИ.

- И технических энтузиастов, которым нравится вникать в детали слоев, задействованных в процессах ИИ.

Что такое большие языковые модели?

Большие языковые модели (LLM) — это передовые системы искусственного интеллекта (ИИ), предназначенные для обработки, понимания и создания текста, подобного человеческому. Они основаны на методах глубокого обучения и обучены на массивных наборах данных, обычно содержащих миллиарды слов из различных источников, таких как веб-сайты, книги и статьи. Это обширное обучение позволяет LLM понимать нюансы языка, грамматики, контекста и даже некоторые аспекты общих знаний.

Некоторые популярные LLM, такие как OpenAI GPT-3, используют тип нейронной сети, называемый преобразователем, который позволяет им решать сложные языковые задачи с замечательным мастерством. Эти модели могут выполнять широкий спектр задач, таких как:

- Отвечая на вопросы

- Обобщающий текст

- Перевод языков

- Генерация контента

- Даже участие в интерактивных беседах с пользователями

Поскольку LLM продолжают развиваться, они обладают большим потенциалом для улучшения и автоматизации различных приложений в разных отраслях, от обслуживания клиентов и создания контента до образования и исследований. Однако они также вызывают этические и социальные проблемы, такие как предвзятое поведение или неправильное использование, которые необходимо решать по мере развития технологий.

Основные факторы при построении корпуса данных LLM

Вам необходимо создать комплексный корпус данных для успешного обучения языковых моделей. Этот процесс предполагает сбор обширных данных и обеспечение их высокого качества и актуальности. Давайте рассмотрим ключевые аспекты, которые существенно влияют на разработку эффективной библиотеки данных для обучения языковой модели.

Отдавайте приоритет качеству данных, а не количеству

Большой набор данных имеет основополагающее значение для обучения языковых моделей. Тем не менее, качеству данных придается большое значение. Модели, обученные на обширных, но плохо структурированных данных, могут давать неточные результаты.

И наоборот, меньшие по размеру и тщательно подобранные наборы данных часто приводят к более высокой производительности. Эта реальность показывает важность сбалансированного подхода к сбору данных. Репрезентативные, разнообразные и соответствующие предполагаемому объему модели данные требуют тщательного отбора, очистки и организации.

Выберите подходящие источники данных

Выбор источников данных должен соответствовать конкретным целям применения модели.

- Модели, генерирующие диалог, выиграют от таких источников, как беседы и интервью, которые неоценимы.

- Модели, ориентированные на генерацию кода, выиграют от хорошо документированных репозиториев кода.

- Литературные произведения и сценарии предлагают богатый учебный материал для тех, кто занимается творческим письмом.

Вы должны включить данные, охватывающие предполагаемые языки и темы. Это поможет вам адаптировать модель для эффективной работы в назначенной области.

Используйте генерацию синтетических данных

Расширение вашего набора данных синтетическими данными может заполнить пробелы и расширить его диапазон. Вы можете использовать увеличение данных, модели генерации текста и генерацию на основе правил для создания искусственных данных, отражающих реальные закономерности. Эта стратегия расширяет разнообразие обучающего набора, повышая устойчивость модели и помогая уменьшить систематические ошибки.

Обязательно проверяйте качество синтетических данных, чтобы они положительно влияли на способность модели понимать и генерировать язык в целевой области.

Внедрить автоматизированный сбор данных

Автоматизация процесса сбора данных облегчает последовательную интеграцию свежих и актуальных данных. Этот подход упрощает сбор данных, повышает масштабируемость и воспроизводимость.

Вы можете эффективно собирать различные наборы данных, используя инструменты веб-скрапинга, API и платформы приема данных. Вы можете настроить эти инструменты, чтобы сосредоточиться на высококачественных и актуальных данных. Они оптимизируют обучающий материал для модели. Вы должны постоянно контролировать эти автоматизированные системы, чтобы поддерживать их точность и этическую целостность.

Популярные примеры больших языковых моделей

Вот несколько ярких примеров LLM, широко используемых в различных отраслевых вертикалях:

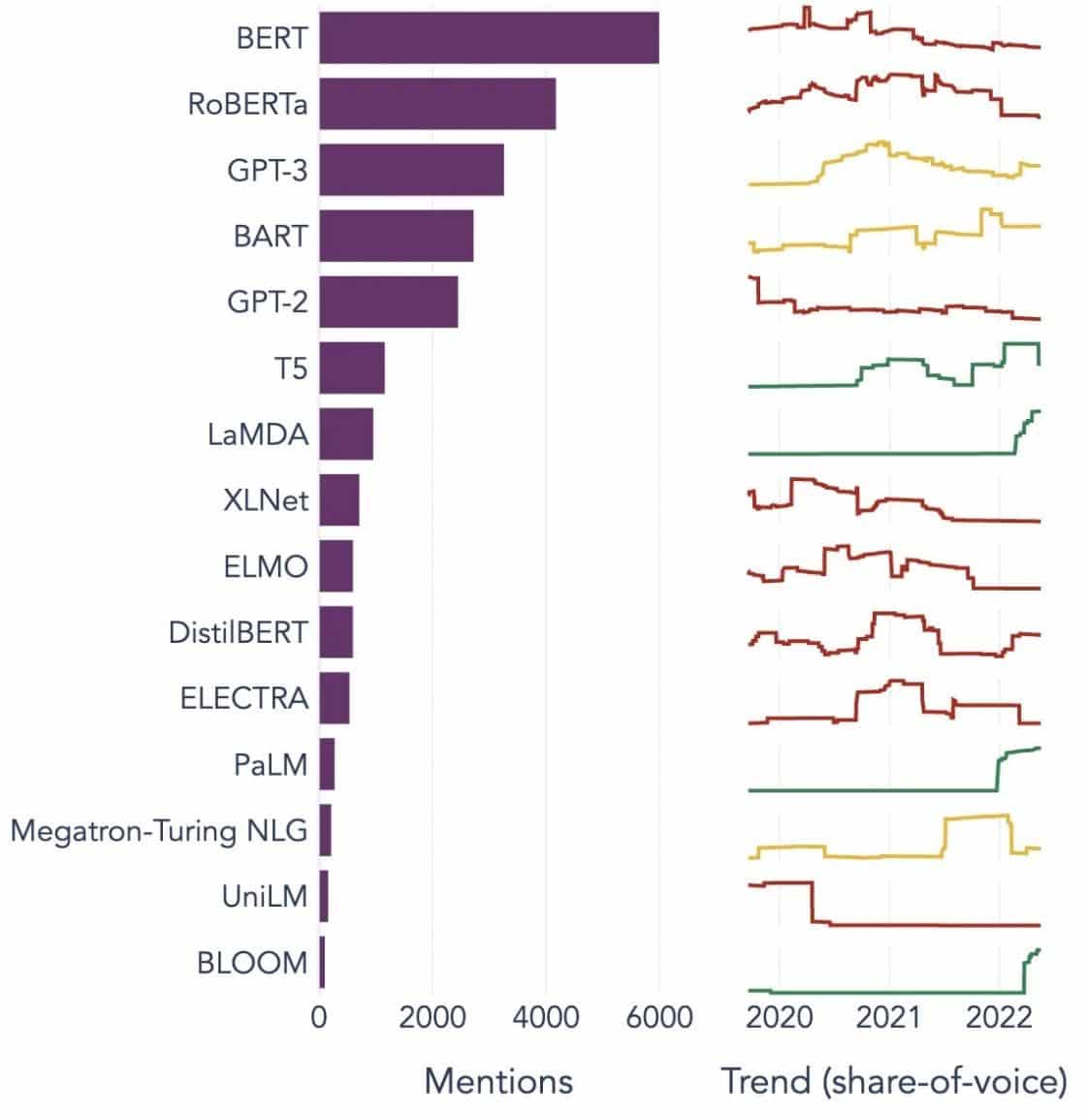

Image Source: На пути к науке о данных

Понимание строительных блоков больших языковых моделей (LLM)

Чтобы полностью понять возможности и работу LLM, важно ознакомиться с некоторыми ключевыми понятиями. К ним относятся:

Вложение слов

Это относится к практике перевода слов в числовой формат, который могут интерпретировать модели ИИ. По сути, встраивание слов — это язык ИИ. Каждое слово представлено в виде многомерного вектора, который инкапсулирует его семантическое значение на основе его контекста в обучающих данных. Эти векторы позволяют ИИ понимать отношения и сходства между словами, улучшая понимание и производительность модели.

Механизмы внимания

Эти сложные компоненты помогают модели ИИ отдавать приоритет определенным элементам входного текста по сравнению с другими при создании вывода. Например, в предложении, наполненном различными чувствами, механизм внимания может придать больший вес словам, несущих чувства. Эта стратегия позволяет ИИ генерировать более контекстуально точные и детализированные ответы.

Трансформаторы

Преобразователи представляют собой усовершенствованный тип архитектуры нейронной сети, широко используемый в исследованиях LLM. Что отличает трансформеров, так это их механизм самоконтроля. Этот механизм позволяет модели взвешивать и рассматривать все части входных данных одновременно, а не в последовательном порядке. Результатом является улучшение обработки длинных зависимостей в тексте, что является общей проблемой в задачах обработки естественного языка.

Тонкая настройка

Даже самые продвинутые LLM требуют некоторой адаптации, чтобы преуспеть в конкретных задачах или областях. Именно здесь вступает в действие тонкая настройка. После первоначального обучения модели на большом наборе данных ее можно дополнительно уточнить или «тонко настроить» на меньшем, более конкретном наборе данных. Этот процесс позволяет модели адаптировать свои общие способности понимания языка к более специализированной задаче или контексту.

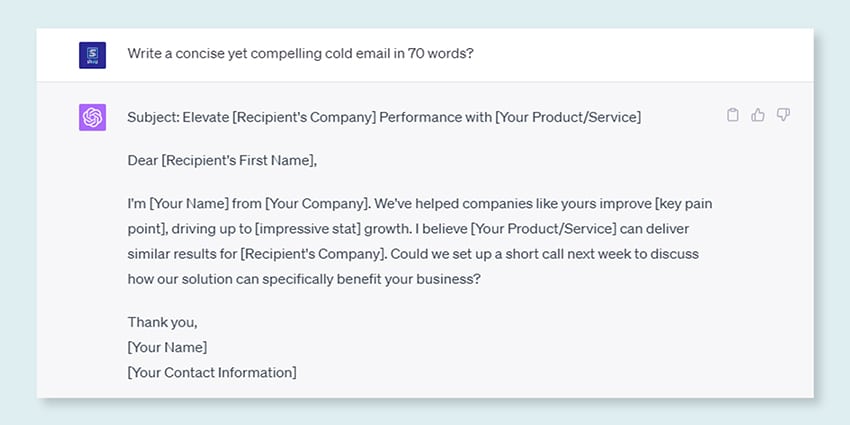

Быстрый инжиниринг

Подсказки ввода служат отправной точкой для LLM для создания выходных данных. Эффективное создание этих подсказок, практика, известная как разработка подсказок, может сильно повлиять на качество ответов модели. Это смесь искусства и науки, требующая четкого понимания того, как модель интерпретирует подсказки и генерирует ответы.

Смещение

Поскольку LLM учатся на данных, на которых они обучаются, любая предвзятость, присутствующая в этих данных, может проникнуть в поведение модели. Это может проявляться как дискриминационные или несправедливые тенденции в результатах модели. Устранение и смягчение этих предубеждений является серьезной проблемой в области ИИ и важным аспектом разработки этически обоснованных LLM.

Интерпретируемость

Учитывая сложность LLM, понять, почему они принимают определенные решения или генерируют определенные результаты, может быть непросто. Эта характеристика, известная как интерпретируемость, является ключевой областью текущих исследований. Повышение интерпретируемости не только помогает в устранении неполадок и уточнении моделей, но также повышает доверие и прозрачность систем ИИ.

Как модели LLM обучаются?

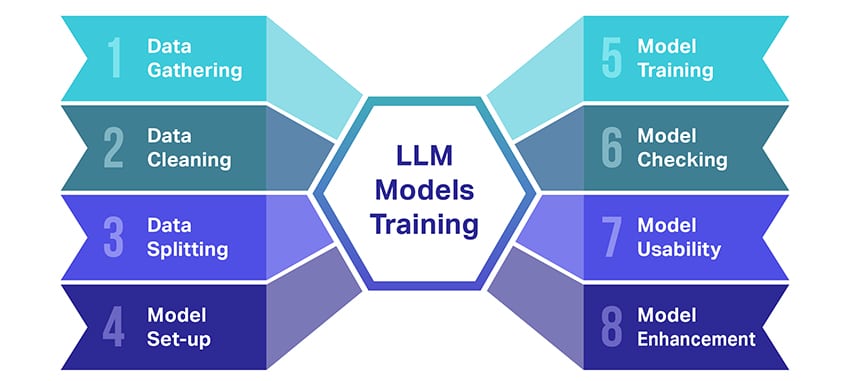

Обучение больших языковых моделей (LLM) — это настоящий подвиг, который включает в себя несколько важных шагов. Вот упрощенное пошаговое описание процесса:

- Сбор текстовых данных: Обучение LLM начинается со сбора большого количества текстовых данных. Эти данные могут поступать из книг, веб-сайтов, статей или платформ социальных сетей. Цель состоит в том, чтобы захватить богатое разнообразие человеческого языка.

- Очистка данных: Затем необработанные текстовые данные упорядочиваются в процессе, называемом предварительной обработкой. Сюда входят такие задачи, как удаление ненужных символов, разбиение текста на более мелкие части, называемые токенами, и преобразование всего этого в формат, с которым может работать модель.

- Разделение данных: Затем чистые данные разбиваются на два набора. Один набор, обучающие данные, будет использоваться для обучения модели. Другой набор, проверочные данные, будет использоваться позже для проверки производительности модели.

- Настройка модели: Затем определяется структура LLM, известная как архитектура. Это включает в себя выбор типа нейронной сети и определение различных параметров, таких как количество слоев и скрытых элементов в сети.

- Обучение модели: Теперь начинается настоящее обучение. Модель LLM учится, просматривая обучающие данные, делая прогнозы на основе того, что она уже узнала, а затем корректируя свои внутренние параметры, чтобы уменьшить разницу между ее прогнозами и фактическими данными.

- Проверка модели: Обучение модели LLM проверяется с использованием проверочных данных. Это помогает увидеть, насколько хорошо работает модель, и настроить параметры модели для повышения производительности.

- Использование модели: После обучения и оценки модель LLM готова к использованию. Теперь его можно интегрировать в приложения или системы, где он будет генерировать текст на основе новых входных данных.

- Улучшение модели: Наконец, всегда есть место для улучшения. Модель LLM можно со временем уточнять, используя обновленные данные или корректируя настройки на основе обратной связи и реального использования.

Помните, что этот процесс требует значительных вычислительных ресурсов, таких как мощные процессоры и большое хранилище, а также специальных знаний в области машинного обучения. Вот почему этим обычно занимаются специализированные исследовательские организации или компании, имеющие доступ к необходимой инфраструктуре и опыту.

Полагается ли LLM на контролируемое или неконтролируемое обучение?

Большие языковые модели обычно обучаются с использованием метода, называемого обучением с учителем. Проще говоря, это означает, что они учатся на примерах, которые показывают им правильные ответы.

Итак, если вы скармливаете LLM предложение, он пытается предсказать следующее слово или фразу на основе того, что он узнал из примеров. Таким образом, он учится генерировать текст, который имеет смысл и соответствует контексту.

Тем не менее, иногда LLM также используют обучение без учителя. Это все равно, что позволить ребенку исследовать комнату, полную разных игрушек, и изучать их самостоятельно. Модель смотрит на немаркированные данные, шаблоны обучения и структуры, не получая при этом «правильных» ответов.

Обучение с учителем использует данные, которые были помечены входными и выходными данными, в отличие от обучения без учителя, которое не использует помеченные выходные данные.

Короче говоря, LLM в основном обучаются с помощью обучения с учителем, но они также могут использовать обучение без учителя для расширения своих возможностей, например, для исследовательского анализа и уменьшения размерности.

Какой объем данных (в ГБ) необходим для обучения большой языковой модели?

Мир возможностей для распознавания речевых данных и голосовых приложений огромен, и они используются в нескольких отраслях для множества приложений.

Обучение большой языковой модели не является универсальным процессом, особенно когда речь идет о необходимых данных. Это зависит от кучи вещей:

- Дизайн модели.

- Какую работу он должен выполнять?

- Тип данных, которые вы используете.

- Насколько хорошо вы хотите, чтобы он работал?

Тем не менее, для обучения LLM обычно требуется огромное количество текстовых данных. Но о какой массе мы говорим? Ну, подумайте не только о гигабайтах (ГБ). Обычно мы рассматриваем терабайты (ТБ) или даже петабайты (ПБ) данных.

Рассмотрим GPT-3, один из крупнейших LLM. Он обучается на 570 ГБ текстовых данных. Меньшим LLM может потребоваться меньше — может быть, 10–20 ГБ или даже 1 ГБ гигабайт, — но это все равно много.

Но дело не только в размере данных. Качество тоже имеет значение. Данные должны быть чистыми и разнообразными, чтобы модель могла эффективно учиться. И вы не можете забыть о других ключевых элементах головоломки, таких как необходимая вычислительная мощность, алгоритмы, которые вы используете для обучения, и настройка вашего оборудования. Все эти факторы играют большую роль в обучении LLM.

Возникновение больших языковых моделей: почему они важны

LLM больше не просто концепция или эксперимент. Они играют все более важную роль в нашем цифровом ландшафте. Но почему это происходит? Что делает эти LLM такими важными? Давайте углубимся в некоторые ключевые факторы.

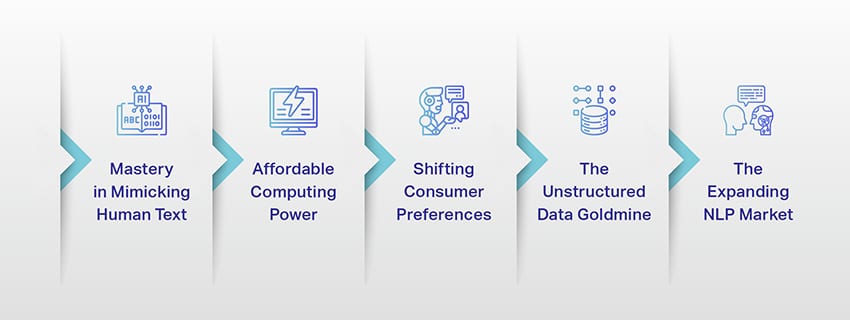

Мастерство имитации человеческого текста

LLM изменили то, как мы справляемся с языковыми задачами. Эти модели, созданные с использованием надежных алгоритмов машинного обучения, способны понимать нюансы человеческого языка, включая контекст, эмоции и даже сарказм в некоторой степени. Эта способность имитировать человеческий язык не просто новинка, она имеет важные последствия.

Расширенные возможности LLM по генерации текста могут улучшить все, от создания контента до взаимодействия со службой поддержки клиентов.

Представьте, что вы можете задать цифровому ассистенту сложный вопрос и получить ответ, который не только имеет смысл, но и связен, актуален и представлен в разговорном тоне. Это то, что позволяют LLM. Они способствуют более интуитивному и увлекательному взаимодействию человека с машиной, обогащают пользовательский опыт и демократизируют доступ к информации.

Доступная вычислительная мощность

Рост LLM был бы невозможен без параллельных разработок в области вычислительной техники. В частности, демократизация вычислительных ресурсов сыграла значительную роль в развитии и внедрении LLM.

Облачные платформы предлагают беспрецедентный доступ к высокопроизводительным вычислительным ресурсам. Таким образом, даже небольшие организации и независимые исследователи могут обучать сложные модели машинного обучения.

Более того, усовершенствования процессоров (таких как GPU и TPU) в сочетании с распространением распределенных вычислений сделали возможным обучение моделей с миллиардами параметров. Эта повышенная доступность вычислительной мощности способствует росту и успеху LLM, что приводит к большему количеству инноваций и приложений в этой области.

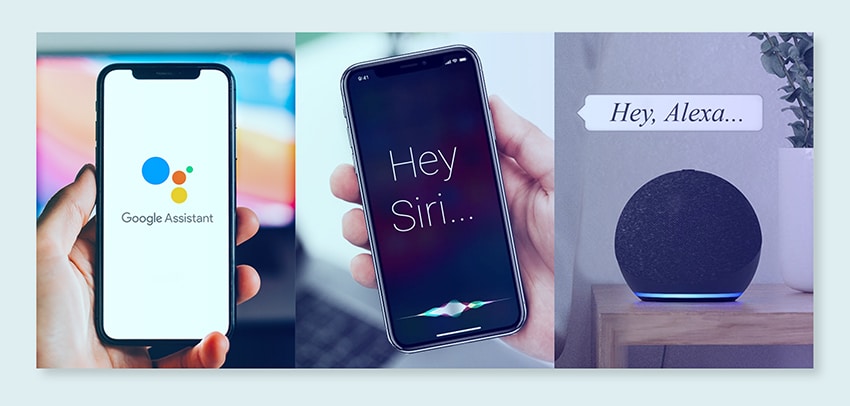

Изменение потребительских предпочтений

Сегодня потребители не просто хотят получить ответы; они хотят увлекательных и родственных взаимодействий. Поскольку все больше людей растут с использованием цифровых технологий, становится очевидным, что потребность в технологиях, которые кажутся более естественными и похожими на человека, возрастает. LLM предлагают непревзойденную возможность оправдать эти ожидания. Генерируя человекоподобный текст, эти модели могут создавать увлекательные и динамичные цифровые впечатления, которые могут повысить удовлетворенность и лояльность пользователей. Будь то чат-боты с искусственным интеллектом, обеспечивающие обслуживание клиентов, или голосовые помощники, предоставляющие обновления новостей, LLM открывают эру искусственного интеллекта, который лучше нас понимает.

Золотая жила неструктурированных данных

Неструктурированные данные, такие как электронные письма, сообщения в социальных сетях и отзывы клиентов, являются сокровищницей идей. Подсчитано, что более 80% корпоративных данных неструктурированы и растут со скоростью 55% в год. Эти данные — золотая жила для бизнеса, если их правильно использовать.

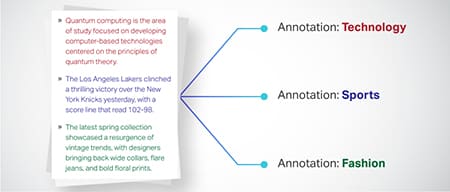

Здесь в игру вступают LLM с их способностью обрабатывать и понимать такие данные в масштабе. Они могут выполнять такие задачи, как анализ тональности, классификация текста, извлечение информации и многое другое, тем самым предоставляя ценную информацию.

Будь то выявление тенденций из сообщений в социальных сетях или оценка настроений клиентов по отзывам, LLM помогают предприятиям ориентироваться в большом объеме неструктурированных данных и принимать решения на основе данных.

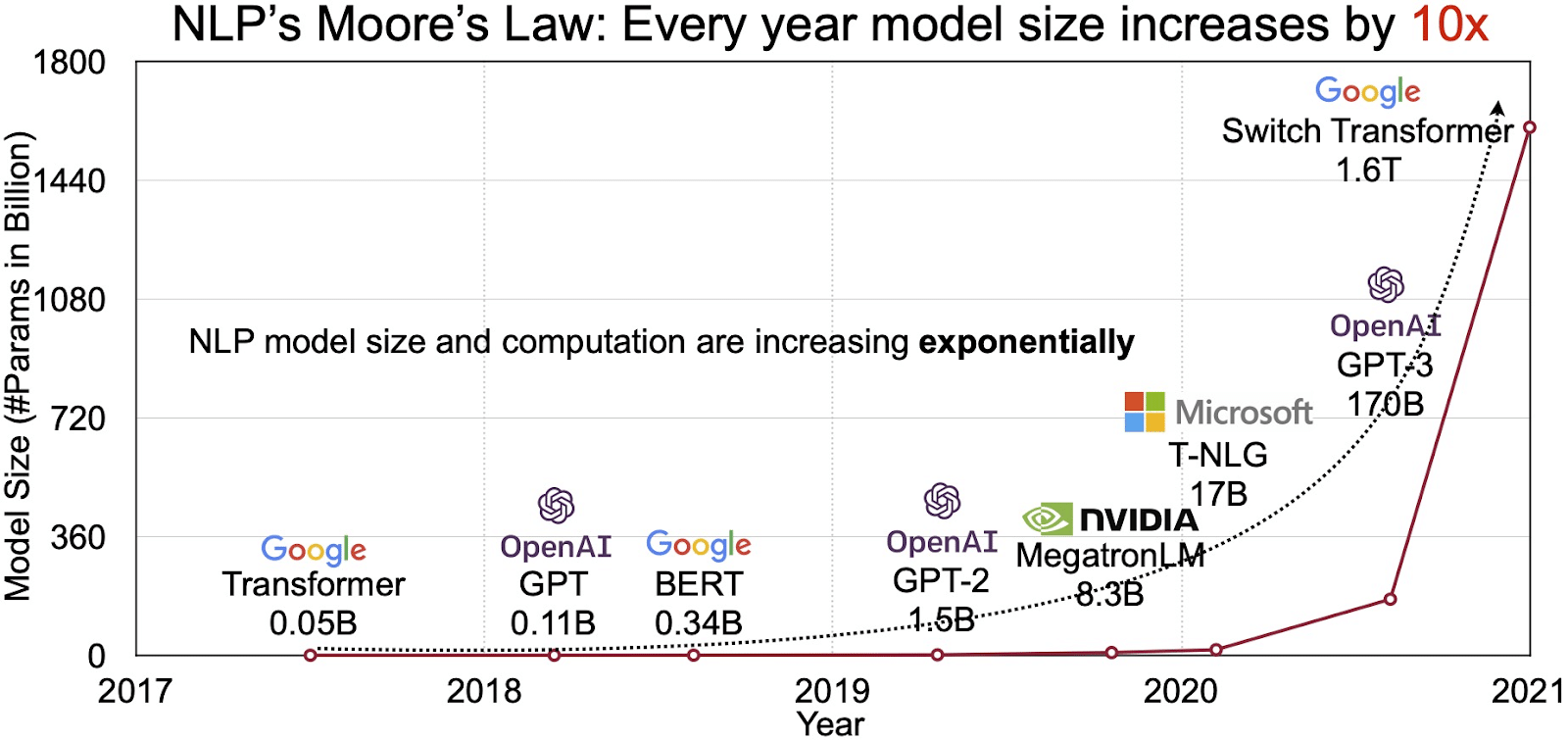

Расширяющийся рынок НЛП

Потенциал LLM отражается в быстро растущем рынке обработки естественного языка (NLP). Аналитики прогнозируют расширение рынка НЛП с 11 миллиардов долларов в 2020 году до более чем 35 миллиардов долларов к 2026 году. Но расширяется не только размер рынка. Сами модели тоже растут, как по физическим размерам, так и по количеству обрабатываемых параметров. Эволюция LLM на протяжении многих лет, как показано на рисунке ниже (источник изображения: ссылка), подчеркивает их растущую сложность и возможности.

Популярные варианты использования больших языковых моделей

Вот некоторые из лучших и наиболее распространенных вариантов использования LLM:

- Создание текста на естественном языке: Модели больших языков (LLM) сочетают в себе возможности искусственного интеллекта и вычислительной лингвистики для автономного создания текстов на естественном языке. Они могут удовлетворить различные потребности пользователей, такие как написание статей, создание песен или участие в беседах с пользователями.

- Перевод через машины: LLM можно эффективно использовать для перевода текста между любой парой языков. Эти модели используют алгоритмы глубокого обучения, такие как рекуррентные нейронные сети, для понимания лингвистической структуры как исходного, так и целевого языков, тем самым облегчая перевод исходного текста на нужный язык.

- Создание оригинального контента: LLM открыли машинам возможности для создания связного и логичного контента. Этот контент можно использовать для создания сообщений в блогах, статей и других типов контента. Модели используют свой глубокий опыт глубокого обучения для форматирования и структурирования контента новым и удобным для пользователя способом.

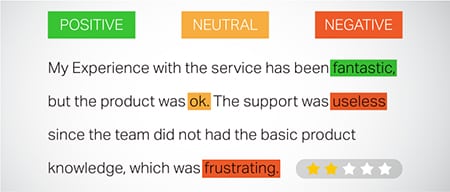

- Анализ настроений: Одним из интригующих приложений больших языковых моделей является анализ настроений. При этом модель обучается распознавать и классифицировать эмоциональные состояния и чувства, присутствующие в аннотированном тексте. Программное обеспечение может идентифицировать такие эмоции, как позитивность, негативность, нейтральность и другие сложные чувства. Это может дать ценную информацию об отзывах и мнениях клиентов о различных продуктах и услугах.

- Понимание, обобщение и классификация текста: LLM создают жизнеспособную структуру программного обеспечения ИИ для интерпретации текста и его контекста. Поручая модели понимать и анализировать огромные объемы данных, LLM позволяют моделям ИИ понимать, обобщать и даже классифицировать текст в различных формах и шаблонах.

- Отвечая на вопросы: Модели большого языка предоставляют системам QA возможность точно воспринимать запросы пользователя на естественном языке и отвечать на них. Популярные примеры этого варианта использования включают ChatGPT и BERT, которые изучают контекст запроса и просеивают обширную коллекцию текстов, чтобы предоставить соответствующие ответы на вопросы пользователей.

Интеграция безопасности и соответствия требованиям в стратегии данных LLM

Внедрение надежных мер безопасности и соответствия требованиям в системы сбора и обработки данных LLM может помочь вам обеспечить прозрачное, безопасное и этичное использование данных. Этот подход включает в себя несколько ключевых действий:

- Внедрить надежное шифрование: Защитите данные при хранении и передаче, используя надежные методы шифрования. Этот шаг защищает информацию от несанкционированного доступа и взлома.

- Установите контроль доступа и аутентификацию: Настройте системы для проверки личности пользователей и ограничения доступа к данным. Это гарантирует, что только уполномоченный персонал сможет взаимодействовать с конфиденциальной информацией.

- Интегрируйте системы регистрации и мониторинга: развертывание систем для отслеживания использования данных и выявления потенциальных угроз безопасности. Такой упреждающий мониторинг помогает поддерживать целостность и безопасность экосистемы данных.

- Соблюдайте стандарты соответствия: Соблюдайте соответствующие правила, такие как GDPR, HIPAA и PCI DSS, которые регулируют безопасность и конфиденциальность данных. Регулярные аудиты и проверки проверяют соответствие, гарантируя, что практика соответствует отраслевым правовым и этическим стандартам.

- Установите правила использования этических данных: Разработать и обеспечить соблюдение политик, диктующих справедливое, прозрачное и подотчетное использование данных. Эти рекомендации помогают поддерживать доверие заинтересованных сторон и обеспечивают безопасную среду обучения для LLM.

Эти действия в совокупности укрепляют практику управления данными для обучения LLM. Это создает основу доверия и безопасности, которая приносит пользу всем заинтересованным сторонам.

Тонкая настройка большой языковой модели

Тонкая настройка большой языковой модели включает в себя тщательный процесс аннотирования. Shaip, с его опытом в этой области, может значительно помочь в этом начинании. Вот некоторые методы аннотирования, используемые для обучения таких моделей, как ChatGPT:

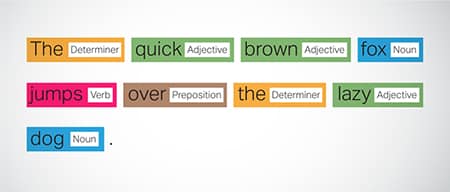

Добавление тегов части речи (POS)

Слова в предложениях помечаются с указанием их грамматической функции, такой как глаголы, существительные, прилагательные и т. д. Этот процесс помогает модели понять грамматику и связи между словами.

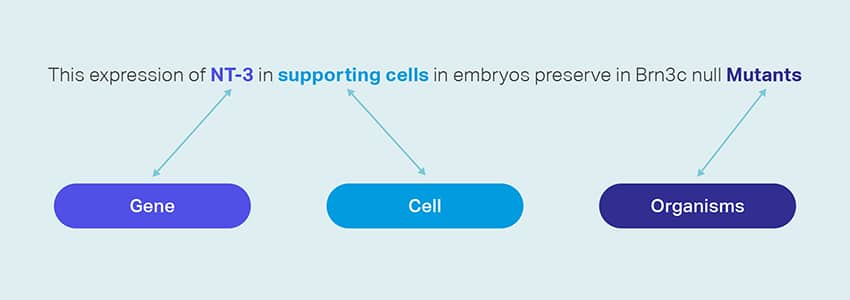

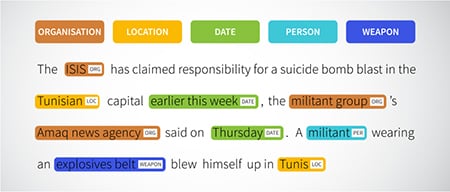

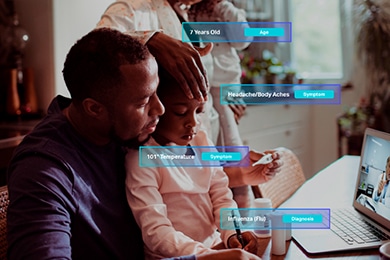

Распознавание именованных сущностей (NER)

Именованные объекты, такие как организации, места и люди в предложении, помечаются. Это упражнение помогает модели интерпретировать семантическое значение слов и фраз и дает более точные ответы.

Анализ настроений

Текстовым данным назначаются метки настроений, такие как положительное, нейтральное или отрицательное, что помогает модели понять эмоциональный оттенок предложений. Это особенно полезно при ответах на вопросы, связанные с эмоциями и мнениями.

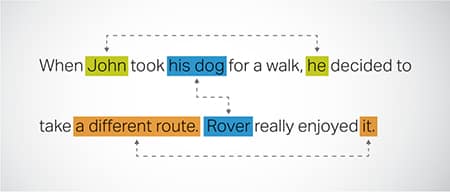

Разрешение Coreference

Выявление и разрешение случаев, когда один и тот же объект упоминается в разных частях текста. Этот шаг помогает модели понять контекст предложения, что приводит к связным ответам.

Классификация текста

Текстовые данные классифицируются по предопределенным группам, таким как обзоры продуктов или новостные статьи. Это помогает модели различать жанр или тему текста, генерируя более подходящие ответы.

Шаип может собирать обучающие данные с помощью веб-сканирования из различных секторов, таких как банковское дело, страхование, розничная торговля и телекоммуникации. Мы можем предоставить текстовые аннотации (NER, анализ тональности и т. д.), облегчить многоязычный LLM (перевод) и помочь в создании таксономии, извлечении / оперативном проектировании.

Shaip имеет обширный репозиторий готовых наборов данных. Наш каталог медицинских данных может похвастаться обширной коллекцией деидентифицированных, безопасных и качественных данных, подходящих для инициатив искусственного интеллекта, моделей машинного обучения и обработки естественного языка.

Точно так же наш каталог речевых данных — это сокровищница высококачественных данных, идеально подходящих для продуктов распознавания голоса, позволяющих эффективно обучать модели AI/ML. У нас также есть впечатляющий каталог данных компьютерного зрения с широким спектром изображений и видеоданных для различных приложений.

Мы даже бесплатно предлагаем открытые наборы данных в изменяемой и удобной форме для использования в ваших проектах искусственного интеллекта и машинного обучения. Эта обширная библиотека данных ИИ позволяет более эффективно и точно разрабатывать модели ИИ и машинного обучения.

Сбор данных и процесс аннотации Shaip

Когда дело доходит до сбора данных и аннотации, Шаип следует оптимизированному рабочему процессу. Вот как выглядит процесс сбора данных:

Идентификация исходных веб-сайтов

Первоначально веб-сайты определяются с использованием выбранных источников и ключевых слов, соответствующих требуемым данным.

Web Scraping

Как только соответствующие веб-сайты определены, Shaip использует свой собственный инструмент для сбора данных с этих сайтов.

Предварительная обработка текста

Собранные данные проходят первоначальную обработку, которая включает в себя разделение и синтаксический анализ предложений, что делает их пригодными для дальнейших шагов.

аннотирование

Предварительно обработанные данные аннотируются для извлечения именованных объектов. Этот процесс включает в себя идентификацию и маркировку важных элементов в тексте, таких как имена людей, организации, места и т. д.

Извлечение отношений

На последнем этапе определяются и соответствующим образом аннотируются типы отношений между идентифицированными объектами. Это помогает в понимании смысловых связей между различными компонентами текста.

Предложение Шаипа

Шаип предлагает широкий спектр услуг, помогающих организациям управлять, анализировать и максимально эффективно использовать свои данные.

Веб-скрейпинг данных

Одной из ключевых услуг, предлагаемых Shaip, является очистка данных. Это включает в себя извлечение данных из URL-адресов, специфичных для домена. Используя автоматизированные инструменты и методы, Shaip может быстро и эффективно собирать большие объемы данных с различных веб-сайтов, руководств по продуктам, технической документации, онлайн-форумов, онлайн-обзоров, данных обслуживания клиентов, отраслевых нормативных документов и т. д. Этот процесс может быть бесценным для предприятий, когда сбор релевантных и конкретных данных из множества источников.

Машинный перевод

Разрабатывайте модели, используя обширные многоязычные наборы данных в сочетании с соответствующими транскрипциями для перевода текста на разные языки. Этот процесс помогает устранить языковые препятствия и способствует доступности информации.

Извлечение и создание таксономии

Shaip может помочь с извлечением и созданием таксономии. Это включает в себя классификацию и категоризацию данных в структурированном формате, отражающем отношения между различными точками данных. Это может быть особенно полезно для предприятий при организации своих данных, делая их более доступными и удобными для анализа. Например, в сфере электронной коммерции данные о продуктах могут быть классифицированы по типу продукта, бренду, цене и т. д., что упрощает для клиентов навигацию по каталогу продуктов.

Сбор данных

Наши услуги по сбору данных предоставляют важные реальные или синтетические данные, необходимые для обучения алгоритмов генеративного ИИ и повышения точности и эффективности ваших моделей. Данные беспристрастны, этичны и ответственны, с учетом конфиденциальности и безопасности данных.

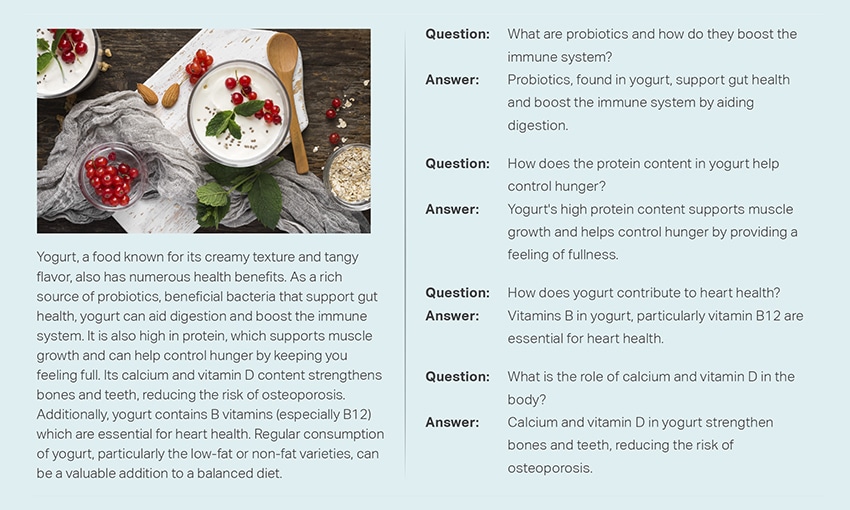

Вопрос и ответ

Ответы на вопросы (QA) — это область обработки естественного языка, ориентированная на автоматические ответы на вопросы на человеческом языке. Системы контроля качества обучаются на обширном тексте и коде, что позволяет им обрабатывать различные типы вопросов, включая фактические, определяющие и основанные на мнениях. Знание предметной области имеет решающее значение для разработки моделей контроля качества, адаптированных к конкретным областям, таким как поддержка клиентов, здравоохранение или цепочка поставок. Однако подходы генеративного контроля качества позволяют моделям генерировать текст без знания предметной области, полагаясь исключительно на контекст.

Наша команда специалистов может тщательно изучить исчерпывающие документы или руководства для создания пар «вопрос-ответ», облегчая создание генеративного ИИ для бизнеса. Этот подход может эффективно решать запросы пользователей, извлекая соответствующую информацию из обширного корпуса. Наши сертифицированные эксперты обеспечивают создание высококачественных пар вопросов и ответов, которые охватывают различные темы и области.

Обобщение текста

Наши специалисты способны упорядочить всесторонние разговоры или длинные диалоги, представляя краткие и содержательные резюме из обширных текстовых данных.

Генерация текста

Обучайте модели, используя широкий набор данных текста в различных стилях, таких как новостные статьи, художественная литература и поэзия. Затем эти модели могут генерировать различные типы контента, включая новости, записи в блогах или сообщения в социальных сетях, предлагая экономичное и экономящее время решение для создания контента.

Распознавание речи

Разрабатывайте модели, способные понимать разговорный язык для различных приложений. Сюда входят голосовые помощники, программное обеспечение для диктовки и инструменты перевода в реальном времени. Процесс включает в себя использование всеобъемлющего набора данных, состоящего из аудиозаписей разговорной речи в сочетании с соответствующими расшифровками.

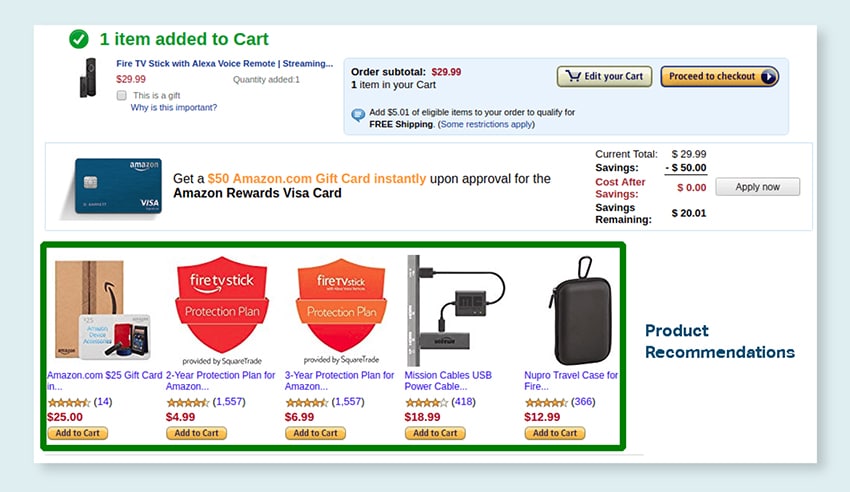

Рекомендации по продукту

Разрабатывайте модели, используя обширные наборы данных об историях покупок клиентов, включая этикетки, указывающие на продукты, которые клиенты склонны покупать. Цель состоит в том, чтобы предоставить точные предложения клиентам, тем самым увеличивая продажи и повышая удовлетворенность клиентов.

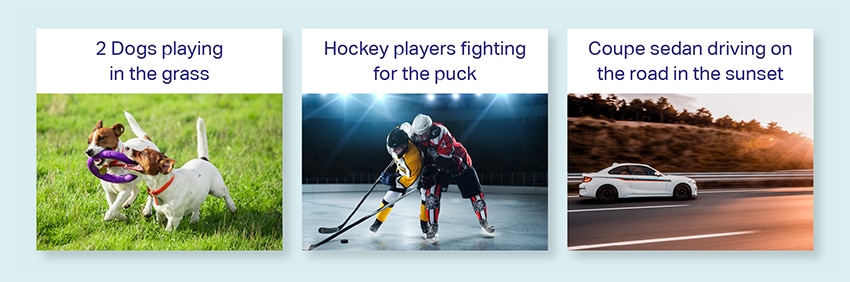

Подписи к изображениям

Измените свой процесс интерпретации изображений с помощью нашего современного сервиса подписей к изображениям на основе искусственного интеллекта. Мы наполняем изображения жизненной силой, создавая точные и контекстуально значимые описания. Это прокладывает путь к инновационным возможностям взаимодействия и взаимодействия с вашим визуальным контентом для вашей аудитории.

Обучение работе с преобразованием текста в речь

Мы предоставляем обширный набор данных, состоящий из аудиозаписей человеческой речи, идеально подходящих для обучения моделей ИИ. Эти модели способны генерировать естественные и привлекательные голоса для ваших приложений, обеспечивая тем самым отличительный и захватывающий звук для ваших пользователей.

Наш разнообразный каталог данных предназначен для многочисленных вариантов использования генеративного ИИ.

Каталог готовых медицинских данных и лицензирование:

- 5M + Записи и аудиозаписи врачей по 31 специальности

- 2M + Медицинские изображения в радиологии и других областях (МРТ, КТ, УЗИ, XR)

- 30k + клинических текстовых документов с добавленной стоимостью и аннотациями отношений

Каталог готовых речевых данных и лицензирование:

- Более 40 50 часов речевых данных (более 100 языков/XNUMX диалектов)

- Охвачено 55+ тем

- Частота дискретизации - 8/16/44/48 кГц

- Тип аудио: спонтанный, по сценарию, монолог, пробуждающие слова.

- Полностью расшифрованные наборы аудиоданных на нескольких языках для разговоров человека с человеком, человека с ботом, человека с агентом в колл-центре, монологов, речей, подкастов и т. д.

Каталог изображений и видеоданных и лицензирование:

- Коллекция изображений продуктов питания/документов

- Коллекция видео домашней безопасности

- Коллекция изображений/видео лиц

- Счета-фактуры, заказы на поставку, сбор документов для OCR

- Сбор изображений для обнаружения повреждений автомобиля

- Коллекция изображений номерных знаков транспортных средств

- Коллекция изображений салона автомобиля

- Коллекция изображений с водителем автомобиля в фокусе

- Коллекция изображений, связанных с модой

Давайте поговорим

Часто задаваемые вопросы (FAQ)

DL — это подполе ML, в котором используются искусственные нейронные сети с несколькими уровнями для изучения сложных закономерностей в данных. ML — это подмножество ИИ, которое фокусируется на алгоритмах и моделях, которые позволяют машинам учиться на данных. Большие языковые модели (LLM) являются подмножеством глубокого обучения и имеют общие черты с генеративным ИИ, поскольку оба являются компонентами более широкой области глубокого обучения.

Большие языковые модели, или LLM, представляют собой обширные и универсальные языковые модели, которые изначально предварительно обучаются на обширных текстовых данных, чтобы понять фундаментальные аспекты языка. Затем они настраиваются для конкретных приложений или задач, что позволяет адаптировать и оптимизировать их для конкретных целей.

Во-первых, большие языковые модели обладают способностью решать широкий спектр задач благодаря их обширному обучению с огромными объемами данных и миллиардами параметров.

Во-вторых, эти модели демонстрируют адаптируемость, поскольку их можно точно настроить с минимальными конкретными данными полевого обучения.

Наконец, производительность LLM постоянно улучшается при включении дополнительных данных и параметров, что со временем повышает их эффективность.

Разработка подсказки включает в себя создание подсказки, адаптированной к конкретной задаче, например указание желаемого языка вывода в задаче перевода. Быстрая разработка, с другой стороны, фокусируется на оптимизации производительности за счет включения знаний предметной области, предоставления выходных примеров или использования эффективных ключевых слов. Быстрый дизайн — это общее понятие, а оперативный инжиниринг — специализированный подход. В то время как быстрое проектирование важно для всех систем, быстрое проектирование становится решающим для систем, требующих высокой точности или производительности.

Существует три типа больших языковых моделей. Каждый тип требует своего подхода к продвижению.

- Общие языковые модели предсказывают следующее слово на основе языка в обучающих данных.

- Модели, настроенные на инструкции, обучены прогнозировать реакцию на инструкции, данные на входе.

- Модели, настроенные на диалог, обучаются вести диалог, похожий на диалог, путем генерации следующего ответа.